Một việc mà Google làm. Amazon làm. Walmart làm. Và theo như các mẩu tin tức được công bố thì Chính phủ Mỹ cũng làm.

Họ làm gì? Họ phân tích “dữ liệu lớn” của hằng hà sa số những dữ liệu ảo thu nhận và lưu trữ được mỗi ngày về hầu như toàn bộ mọi khía cạnh trong đời sống, từ đó xác định các mẫu hành vi, đưa ra các mối tương quan và các đánh giá mang tính dự báo.

Amazon sử dụng dữ liệu khách hàng để đưa ra đề xuất dựa trên lịch sử mua hàng cũ. Google sử dụng dữ liệu tìm kiếm và các thông tin khác nó thu nhận được để bán quảng cáo và phục vụ cho các dịch vụ và sản phẩm khác.

Cơ quan An ninh Quốc gia Mỹ cũng đang thu thập hàng triệu ghi âm cuộc gọi của các khách hàng sử dụng Verizon theo yêu cầu mật của tòa án – “không trừ ai và theo số lượng lớn” và “bất kể họ có đang bị nghi ngờ về hành vi xấu nào không”. Theo tin từ The Guardian và The Washington Post, cơ quan này còn thực hiện chương trình tình báo khác tên là Prism, trong đó họ thu thập dữ liệu trong email, audio chat, video chat, ảnh, tài liệu, tên truy cập từ các công ty mạng hàng đầu như Microsoft, Google, Yahoo, Facebook và Apple, nhằm mục đích theo dõi các mục tiêu bên ngoài nước Mỹ.

Sao lại cần quăng một tấm lưới rộng như vậy chỉ để tìm kiếm một số nhỏ các đối tượng tình nghi khủng bố? Sau lại cần thu thập dữ liệu trên diện rộng như vậy? Jeremy Bash, một cựu quan chức Lầu năm góc, từng làm việc dưới trướng của Leon E. Panetta – nguyên Giám đốc Cơ quan Tình báo Trung ương Mỹ (CIA) đã nói: “Nếu như bạn tìm một cây kim trong đống cỏ khô thì bạn sẽ cần một đống cỏ khô”.

Trong cuốn sách “Big Data” (tên tiếng Việt: Dữ liệu lớn), Viktor Mayer-Schönberger, một giáo sư về quản trị Internet tại Viện nghiên cứu Internet thuộc Đại học Oxford, cùng Kenneth Cukier, quản trị viên dữ liệu (data editor) cho tờ The Economist, đã chỉ ra rằng bản chất của hoạt động tình báo đã thay đổi.

Họ viết:

“Theo tinh thần của Google và Facebook, chúng ta giờ đây phải nhìn nhận rằng con người là tổng hòa của các mối quan hệ xã hội, các tương tác mạng và sự liên kết với nội dung. Để có thể điều tra toàn diện một cá nhân, những nhà nghiên cứu cần phải nhìn vào khoảng rộng nhất mà nửa tối của dữ liệu có thể bao được xoay quanh cá nhân đó – không chỉ là những người mà họ biết, mà cả những người mà những người đó biết, vân vân.”

Cukier và Mayer-Schönberger chỉ ra rằng, phân tích dữ liệu lớn đang thay đổi hoàn toàn cách chúng ta nhìn và xử lí thế giới – họ thậm chí còn so sánh những hệ quả của nó với những hệ quả mà quy trình in ấn mà Gutenberg sáng tạo ra. Trong ấn phẩm này, họ đưa ra cho độc giả một thống kê vừa thú vị vừa đáng báo động về những ảnh hưởng ngày một tăng của dữ liệu lớn lên hầu như tất cả các lĩnh vực: kinh doanh, nhà nước, khoa học, dược, tính riêng tư và thậm chí là lên cả cách chúng ta suy nghĩ. Họ nói rằng, khi ta hiểu được về các cơ chế, chúng ta có thể nhận thức được về nhân quả, từ đó dẫn tới đánh giá tương quan.

Dữ liệu đang tăng trưởng một cách chóng mặt – theo như một nguồn tin nào đó thì thậm chí mỗi năm nó tăng hơn gấp đôi – và các tác giả của cuốn sách này đã khẳng định rằng khi chi phí lưu trữ giảm xuống còn các thuật toán ngày một phát triển thì các công nghệ “nghiền dữ liệu” (data-crunching) vốn trước đây chỉ được sử dụng trong các cơ quan tình báo, các phòng nghiên cứu và các tập đoàn khổng lồ, thì bây giờ đang ngày càng trở nên phổ cập hơn.

Dữ liệu lớn đã dẫn tới sự ra đời của một loạt các công ty mới, giúp các công ty hiện tại thúc đẩy dịch vụ chăm sóc khách hàng và tìm được cách thức tăng trưởng mới. Nhờ có dữ liệu lớn mà Walmart đã phát hiện ra rằng, trước khi cơn bão đổ bộ thì doanh số bán của đèn pin tăng cùng doanh số bán của Pop-Tarts (một món ăn sáng có đường tại Mỹ). Từ đó, các cửa hàng của Walmart bắt đầu bày bán các hộp Pop-Tarts cạnh các đồ tiếp tế cho bão, vừa để “giúp cuộc sống của khách hàng trở nên dễ dàng hơn”, vừa giúp tăng doanh số. Các tác giả cũng dẫn lại việc UPS cài đặt vào hệ thống xe tải các bộ phận cảm biến cùng GPS để có thể kiểm soát nhân viên, tối ưu lộ trình và biết khi nào nên bảo trì phương tiện.

Các đội tuyển bóng chày như Oakland A’s của Billy Beane cũng đã áp dụng thành công cách tiếp cận “nghiền dữ liệu” để theo dõi các vận động viên. Chiến dịch tranh cử năm 2012 của Obama cũng đã sử dụng việc phân tích dữ liệu phức tạp để xây dựng một cỗ máy chính trị cầu kỳ, nhằm phát hiện người ủng hộ và vận động họ bỏ phiếu. Thành phố New York cũng sử dụng phân tích dữ liệu để tìm ra mô hình hiệu quả mới trong mọi thứ, từ cách phản ứng trước thiên tai tới nhận diện các cửa hàng bán thuốc lá lậu, tới việc thông tin cho các thanh tra nhà ở đến những ngôi nhà mà họ cần lưu ý nhất. Trong những năm tới, như Mayer-Schönberger và Cukier tranh luận, dữ liệu lớn sẽ dần dần trở thành “một phần trong những giải pháp đối với các vấn đề toàn cầu như biến đổi khí hậu, xóa bỏ bệnh dịch, củng cố hành chính và phát triển kinh tế.

Đương nhiên là dữ liệu lớn cũng có mặt tối của nó, và các tác giả cũng đã phân tích một cách khéo léo những mối nguy hại mà họ dự đoán sẽ xảy đến. Việc bảo hộ quyền riêng tư sẽ ngày một trở nên khó khăn. Đặc biệt, các chiến lược bảo hộ cũ như “thông báo cho cá nhân, thỏa thuận tự nguyện, hủy đăng ký và nặc danh hóa” sẽ ngày một kém hiệu quả hoặc thậm chí vô hiệu.

Hai tác giả viết: “Mọi công cụ mà chúng ta sử dụng hàng ngày, từ website cho tới các ứng dụng smartphone đều có cài đặt khả năng thu thập dữ liệu cá nhân”. Khi đã có hàng triệu cách để tái sử dụng, tái mục đích và bán lại dữ liệu cho các công ty khác, thật khó để người dùng có thể được xin phép trước khi dữ liệu của họ được “sử dụng cho mục đích thứ cấp”, điều họ sẽ không thể hình dung ra khi ban đầu dữ liệu được thu thập.

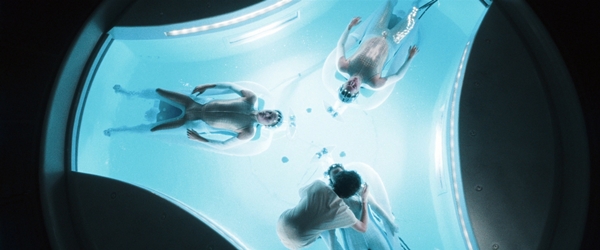

Mối nguy hiểm thứ hai khiến Cukier và Mayer-Schönberger lo ngại có nhiều điểm tương đồng với bối cảnh từ bộ phim viễn tưởng “Minority Report” (Bản báo cáo thiểu số), trong đó chúng ta có thể đưa ra các dự đoán chính xác tới mức ta có thể ra lệnh bắt người trước cả khi họ phạm tội. Các tác giả gợi ý rằng trong tương lai gần, việc phân tích dữ liệu lớn (mà trong phim là thiết bị Pre-Cogs hiện đại) có thể làm nảy sinh tình huống là “việc phán quyết rằng ai có tội có thể được dựa trên việc dự đoán về hành vi tương lai của người đó”.

Thiết bị Pre-cogs trong phim “The Minority Report”

Hiện tại các công ty bảo hiểm và các hội đồng phán quyết phóng thích đã sử dụng việc phân tích dữ liệu để dự đoán các rủi ro, và cũng theo các tác giả, ngày càng nhiều nơi tại Mỹ sử dụng “chính sách dự báo” cùng “dữ liệu nghiền” để “lựa chọn xem phố nào, nhóm nào và các cá nhân nào nên được kiểm soát gắt gao hơn, bởi lẽ thuật toán đã chỉ ra rằng khu vực này có khả năng phạm tội cao”.

Trong một báo cáo của NBC về một cuộc không kích thì “CIA không nhất thiết phải biết là nó đang giết ai”: trong các cuộc không kích thì “các sĩ quan tình báo và những người vận hành máy bay không người lái có thể giết những kẻ tình nghi chỉ cần dựa trên mẫu hành vi của họ – mà không cần nhận diện dương tính”.

Cukier và Mayer-Schönberger cũng chỉ ra, một vấn đề khác liên quan đến việc phụ thuộc vào các dự đoán về tiềm năng hành vi là nó có thể phủ nhận “ý tưởng về suy đoán vô tội”.

Họ viết:

“Nếu như chúng ta có thể buộc con người phải chịu trách nhiệm cho các hành vi tương lai được dự báo, những việc mà biết đâu họ sẽ không bao giờ thực hiện, thì cũng tức là ta phủ định cơ hội lựa chọn đạo đức của con người.”

Cùng lúc đó, họ cũng quan sát được rằng, những dữ liệu lớn làm trầm trọng thêm “một vấn đề đã tồn tại rất lâu: là phụ thuộc vào số liệu, trong khi chúng còn có khả năng sai lệch cao hơn rất nhiều so với ta có thể hình dung”. Họ dẫn ra sự leo thang trong cuộc chiến tranh Việt Nam dưới sự chỉ đạo của Robert S. McNamara (người nguyên là thư ký Bộ Quốc phòng dưới trướng Tổng thống John F. Kennedy và Lyndon B. Johnson) như là một case study điển hình trong “lỗi phân tích dữ liệu”: là người tiên phong áp dụng phân tích dữ liệu, McNamara đã phụ thuộc quá nhiều vào các ma trận như số lượng quân để đo lường tiến trình cuộc chiến tranh; trong khi rõ ràng cuộc chiến tranh Việt Nam là cuộc chiến về ý chí nhiều hơn là về những con số.

Gần đây hơn, ta còn có thể thấy nhiều thất bại khác của phân tích dữ liệu, bao gồm vụ sụp đổ của phố Wall năm 2009, khi đó đã rơi vào khủng hoảng càng nghiêm trọng do các hệ thống giao dịch vô cùng rắc rối phụ thuộc vào thuật toán. Trong cuốn sách best-seller năm 2012 mang tên “The Signal and the Noise” (tạm dịch: Tín hiệu và Âm thanh), nhà thống kê Nate Silver đã chỉ ra các sai lầm các của số liệu trong các lĩnh vực như khoa học động đất, tài chính và nghiên cứu sinh dược. Ông cũng biện luận rằng “việc dự báo trong thời đại của Dữ liệu lớn” đã “không diễn ra quá suôn sẻ” (dẫu rằng bản thân ông lại rất thành công trong việc đưa ra dự báo ở các lĩnh vực như chính trị và bóng chày).

Đồng thời, như một nhà khoa học máy tính kiêm nhạc sĩ Jaron Lanier đã chỉ ra trong cuốn sách mới xuất sắc của ông: “Who Owns the Future” (tạm dịch: Tương lai trong tay ai?”), thì có một sự khác biệt lớn giữa “dữ liệu lớn của khoa học, như dữ liệu về sự hình thành ngân hà, về thiên nhiên, sự bùng nổ của dịch cúm” – vốn yêu cầu rất nhiều công sức nghiên cứu, với “dữ liệu lớn về con người” – vốn là những thứ cũng bất định, đầy mâu thuẫn và thường là không đáng tin cậy như bất kỳ điều gì liên quan tới con người từ trước tới nay.

Đáng ghi nhận là Cukier và Mayer-Schönberger cũng đã nhận ra những hạn chế của số liệu. Đây là cuốn sách có thể giúp chúng ta nhìn nhận được tầm quan trọng của dữ liệu lớn như một công cụ để “lượng hóa và thấu hiểu thế giới”, nhưng nó cũng đồng thời cảnh báo ta không nên trở thành nạn nhân của “nền độc tài dữ liệu”.

Họ viết:

“Chúng ta nên cẩn trọng để không phụ thuộc quá đà vào dữ liệu, thay vì lặp lại sai lầm của Icarus, người đã quá tin tưởng vào năng lực bay của mình để rồi dùng nó sai cách và rơi xuống biển sâu”.

Techtalk via tramdoc