Các CPU hiện đại đều có số lượng bóng bán dẫn khổng lồ, ví dụ CPU Epyc Rome 7nm dành cho máy chủ và trung tâm dữ liệu, mới được AMD giới thiệu vào tuần trước có đến 32 tỷ bóng bán dẫn. Thế nhưng nếu so với con chip AI khổng lồ mà startup Cerebras Systems mới công bố, con số trên chỉ như một cậu bé tí hon.

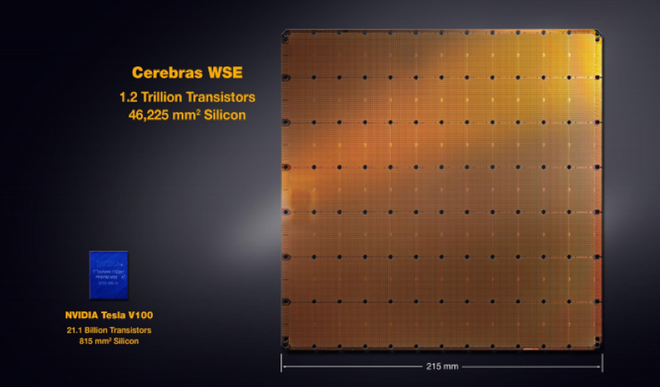

Con chip mới được startup tập trung vào trí tuệ nhân tạo này giới thiệu có tên Wafer Scale Engine (WSE). Là một hình vuông với kích thước hơn 200m mỗi cạnh, con chip này chứa gần 1,2 nghìn tỷ bóng bán dẫn, nhiều gấp hàng chục lần so với các con chip thông thường.

So với Cerebras WSE, bộ xử lý Nvidia Tesla V100 chỉ như một chú bé tí hon.

Chưa hết, con chip WSE này còn có đến 400.000 lõi đại số tuyến tính rải rác (sparse linear algebra) với bộ nhớ trên die chip lên tới 18 GB, tổng băng thông bộ nhớ đạt tới tốc độ 9PB/giây (một PB hay Petabyte bằng khoảng 1 triệu GB). Toàn bộ con chip này được xây dựng dựa trên tiến trình 16nm FinFET của TSMC.

Vì toàn bộ con chip này được xây dựng từ một tấm wafer duy nhất, công ty phải sử dụng nhiều phương pháp định tuyến để đi vòng tránh các lõi hỏng trên die chip, và duy trì cả mảng chip được kết nối ngay cả khi có những lõi hỏng trong một khu vực nào đó trên tấm wafer. Công ty cho biết, họ còn có cả các lõi dự phòng đặt trên die chip, nhưng không thảo luận chi tiết về cách thức của mình.

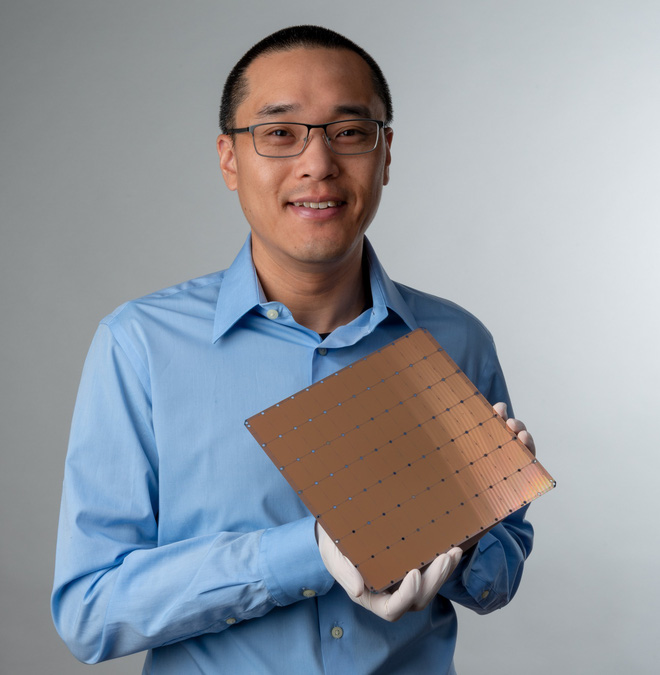

Nhà đồng sáng lập Sean Lie, người chịu trách nhiệm về thiết kế và kiến trúc công nghệ của con chip.

Hệ thống tản nhiệt cho con chip khổng lồ này cũng được thiết kế khác hoàn toàn so với chip thông thường. Bên trên con chip này là một tấm làm mát khổng lồ, với hàng loạt các ống tản nhiệt nước được đặt thẳng đứng để làm mát trực tiếp cho bộ xử lý.

Một bộ xử lý với kích thước và cấu hình khổng lồ như WSE rõ ràng không dành cho các máy tính cá nhân của mọi người. Thay vào đó, WSE dành cho các tác vụ trí tuệ nhân tạo.

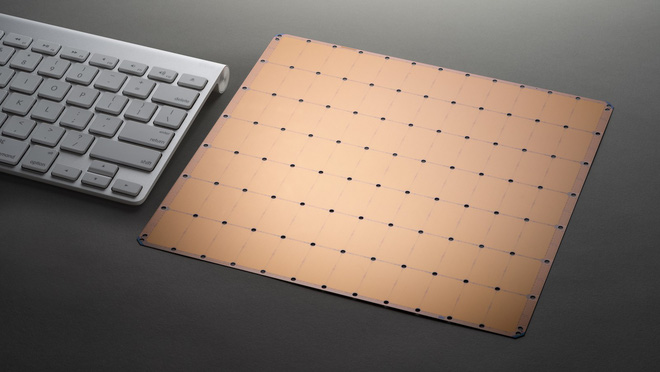

Cạnh con chip WSE còn lớn hơn cả bề rộng bàn phím không dây của máy Mac.

Theo Andrew Feldman, nhà sáng lập của Cerebras Systems, các phần mềm trí tuệ nhân tạo cần một lượng thông tin khổng lồ để cải thiện khả năng xử lý của mình, vì vậy các bộ xử lý cần có tốc độ nhanh nhất có thể để xử lý lượng dữ liệu đó – ngay cả khi nó có kích thước khổng lồ.

Con chip này được Cerebras tạo ra không phải để bán. Kích thước và hệ thống tản nhiệt đặc biệt của nó khiến nó khó có thể kết nối với các hệ thống máy tính thông thường. Thay vào đó, bộ xử lý này sẽ là một phần trong một máy chủ mới được cài đặt trong các trung tâm dữ liệu. Công ty cho biết, họ sẽ thử nghiệm các hệ thống này với hàng loạt khách hàng tiềm năng và bắt đầu xuất xưởng những cỗ máy thương mại trong tháng Mười.

Hệ thống đóng gói và kiểm tra chip do Cerebras tự phát triển.

Cho đến nay Cerebras đã huy động được hơn 100 triệu USD từ các nhà đầu tư của Thung lũng Silicon, bao gồm Benchmark, Andy Bechtolsheim và Sam Altman. Feldman còn có trong tay một đội ngũ 174 kỹ sư và sự hỗ trợ từ TSMC cho việc sản xuất các con chip khổng lồ WSE.

Thị trường chip AI đang có sự tham gia của những ông lớn trong làng công nghệ như Nvidia, Intel và startup của Anh, Graphcore Ltd. Ngoài ra còn có Google với bộ xử lý do họ tự phát triển có tên Tensor Processing Units, dùng để tăng tốc quá trình xử lý AI.

Tham khảo ExtremeTech

Nguồn: Genk.vn