Theo OpenAI, mô hình AI mới có thể xử lý xuyên suốt cả giọng nói, hình ảnh và văn bản theo thời gian thực.

Dù GPT-4 đang là mô hình AI vận hành cho ChatGPT Plus – phiên bản trả phí cao cấp hơn của ChatGPT – nhưng chính Sam Altman, CEO OpenAI vẫn thường cho biết mình "xấu hổ" về trình độ của mô hình này và gọi đây là "mô hình ngốc nghếch nhất … mà mọi người vẫn đang phải sử dụng rất nhiều."

Và trong sự kiện giới thiệu sản phẩm của mình tối qua, OpenAI đã cho thấy quyết tâm sửa chữa lại điều này khi ra mắt một mô hình AI tạo sinh cao cấp mới có tên GPT-4o, với "o" viết tắt cho "omni" (toàn năng) cho thấy các khả năng xử lý mới của mô hình này bao gồm cả văn bản, hội thoại và video.

GPT-4o sẽ được triển khai dần dần trên các sản phẩm dành cho nhà phát triển và người dùng của công ty trong vài tuần tới. Trong khi đó, người dùng ChatGPT Plus sẽ được tiếp cận với mô hình mới này ngay hôm nay.

Không chỉ giao tiếp bằng văn bản, với GPT-4o, ChatGPT có thể tiếp nhận đầu vào bằng nhiều phương thức khác nhau

Kỹ sư trưởng Mira Murati của OpenAI cho biết GPT-4o cung cấp trí thông minh "tương đương GPT-4" nhưng nâng cao khả năng của GPT-4 trên nhiều phương thức và phương tiện truyền thông.

"GPT-4o suy luận xuyên suốt giọng nói, văn bản và hình ảnh," CTO Murati cho biết trong một buổi trình chiếu trực tuyến tại văn phòng OpenAI ở San Francisco. "Và điều này vô cùng quan trọng, bởi vì chúng ta đang nhìn về tương lai của sự tương tác giữa chúng ta và máy móc."

Trong khi GPT-4 Turbo, mô hình "tiên tiến nhất" trước đây của OpenAI, được đào tạo để có thể phân tích hình ảnh, văn bản để hoàn thành các nhiệm vụ như trích xuất văn bản từ hình ảnh hoặc thậm chí mô tả nội dung của những hình ảnh đó, GPT-4o còn có thể thêm cả giọng nói.

GPT-4o nâng cao đáng kể trải nghiệm trên trợ lý trò chuyện ChatGPT của OpenAI. Nền tảng này đã lâu nay có chế độ giọng nói chuyển văn bản thành giọng nói, nhưng GPT-4o tăng cường khả năng này, cho phép người dùng tương tác với ChatGPT giống như với một trợ lý thực sự.

Ví dụ, người dùng có thể hỏi ChatGPT được tăng cường bởi GPT-4o một câu hỏi và gián đoạn ChatGPT trong khi nó đang trả lời. OpenAI cho biết, GPT-4o cung cấp khả năng phản hồi "thời gian thực", và thậm chí có thể nhận ra những khác biệt nhỏ trong giọng nói của người dùng, để tạo ra các giọng nói khác nhau với "nhiều phong cách biểu cảm khác nhau" (bao gồm cả hát).

Khả năng nhận diện và phân tích hình ảnh của ChatGPT trên mô hình mới được cải tiến vượt trội

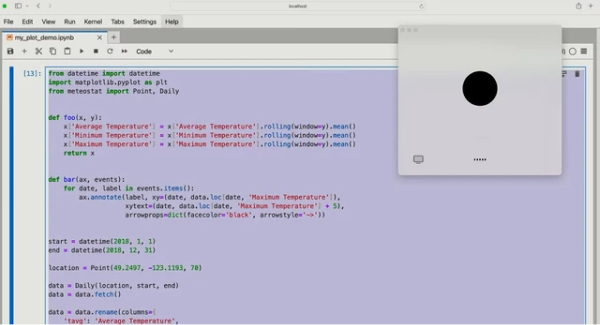

GPT-4o cũng nâng cấp khả năng xử lý hình ảnh của ChatGPT. Với một bức ảnh - hoặc màn hình máy tính - ChatGPT hiện có thể nhanh chóng trả lời các câu hỏi liên quan, từ các chủ đề như "Có gì đang diễn ra trong đoạn mã này?" đến "Nhãn hiệu áo sơ mi này là gì?".

Các tính năng này sẽ tiếp tục phát triển trong tương lai, Murati nói. Trong khi hiện tại GPT-4o có thể nhìn vào một bức ảnh menu bằng một ngôn ngữ khác và dịch nó, trong tương lai, mô hình có thể cho phép ChatGPT "xem" một trận đấu thể thao trực tiếp và giải thích luật chơi cho bạn.

OpenAI cũng khẳng định, GPT-4o sẽ hỗ trợ đa ngôn ngữ với hiệu suất nâng cao cho khoảng 50 ngôn ngữ. Và trên API của OpenAI và Azure OpenAI Service của Microsoft, GPT-4o nhanh gấp đôi, giá rẻ hơn một nửa và có giới hạn tỷ lệ cao hơn so với GPT-4 Turbo, công ty cho biết.

Hiện tại, giọng nói chưa phải là một phần của GPT-4o API cho tất cả khách hàng. OpenAI, với lý do rủi ro lạm dụng, cho biết họ dự định sẽ ra mắt hỗ trợ cho khả năng xử lý âm thanh mới của GPT-4o cho "một nhóm đối tác đáng tin cậy nhỏ" trong vài tuần tới. Nhưng nếu khả năng giao tiếp đa phương tiện mới thực sự hiệu quả như tuyên bố của OpenAI, có lẽ đã đến lúc người dùng không cần đến bàn phím để giao tiếp với máy móc nữa.

GPT-4o có sẵn trên gói miễn phí của ChatGPT từ hôm nay và cho người đăng ký gói ChatGPT Plus và Đội ngũ trả phí của OpenAI với giới hạn tin nhắn "cao gấp 5 lần". (OpenAI lưu ý rằng ChatGPT sẽ tự động chuyển sang GPT-3.5, một mô hình cũ hơn và kém năng lực hơn, khi người dùng chạm đến giới hạn tỷ lệ.) Trải nghiệm ChatGPT giọng nói được nâng cấp nhờ GPT-4o sẽ ra mắt phiên bản alpha cho người dùng Plus trong tháng tới, cùng với các tùy chọn dành cho doanh nghiệp.

Ngoài ra người dùng ChatGPT phiên bản miễn phí cũng được tiếp cận cửa hàng GPT Store, cửa hàng các công cụ và chatbot bên thứ ba được xây dựng trên mô hình AI của OpenAI – một tính năng trước đây chỉ dành cho người dùng trả phí.

Trong một tin liên quan, OpenAI thông báo rằng họ đang làm mới giao diện web của ChatGPT với màn hình chính "hơi hướng đối thoại" và bố cục tin nhắn mới, cùng với phiên bản desktop của ChatGPT cho MacOS giúp người dùng đặt câu hỏi qua phím tắt hoặc chụp và thảo luận về ảnh chụp màn hình. Phiên bản cho Windows sẽ ra mắt trong năm nay.

Trước khi ra mắt GPT-4o ngày hôm nay, nhiều báo cáo dự đoán rằng OpenAI sẽ công bố một công cụ tìm kiếm AI để cạnh tranh với Google và Perplexity, nhưng rõ ràng OpenAI còn đang làm được nhiều hơn thế. Điều thú vị hơn nữa là việc OpenAI ra mắt mô hình mới được diễn ra ngay trước sự kiện nhà phát triển của Google I/O một ngày, nơi nhiều khả năng Google sẽ công bố các sản phẩm AI mới của mình.

GenK