Theo Musk, sự tiến bộ của công nghệ AI hiện nay đang bị cản trở bởi hai yếu tố chính: thiếu hụt nguồn cung cấp các bộ xử lý tiên tiến - như Nvidia H100, vì không dễ để nhanh chóng có được 100 nghìn chiếc - và nguồn cung điện.

Elon Musk, CEO của Tesla và người sáng lập xAI, đã đưa ra những dự đoán táo bạo về sự phát triển của trí tuệ nhân tạo tổng quát (AGI) và đã thảo luận về những thách thức mà ngành công nghiệp AI đang đối mặt. Ông dự đoán rằng AGI có thể vượt qua trí tuệ con người vào năm sau hoặc vào năm 2026, nhưng sẽ cần một số lượng lớn các bộ xử lý để huấn luyện, điều này đòi hỏi một lượng lớn điện năng, theo báo cáo của Reuters.

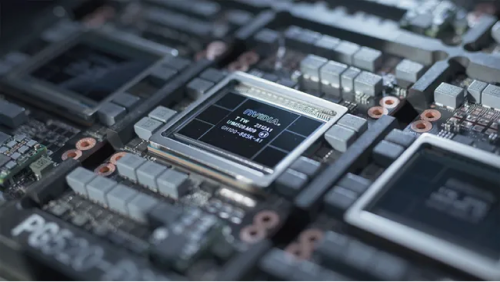

Dự án của Musk, xAI, hiện đang huấn luyện phiên bản thứ hai của mô hình ngôn ngữ lớn Grok và dự kiến sẽ hoàn thành giai đoạn huấn luyện tiếp theo vào tháng Năm. Việc huấn luyện mô hình phiên bản 2 của Grok đã yêu cầu tới 20,000 GPU Nvidia H100, và Musk dự kiến rằng các phiên bản tương lai sẽ yêu cầu nhiều tài nguyên hơn nữa, với mô hình Grok 3 cần khoảng 100,000 chip Nvidia H100 để huấn luyện.

Theo Musk, sự tiến bộ của công nghệ AI hiện nay đang bị cản trở bởi hai yếu tố chính: thiếu hụt nguồn cung cấp các bộ xử lý tiên tiến - như Nvidia H100, vì không dễ để nhanh chóng có được 100,000 chiếc - và nguồn cung điện.

GPU Nvidia H100 tiêu thụ khoảng 700W khi hoạt động hết công suất, do đó 100,000 GPU cho công việc AI và HPC có thể tiêu thụ tới 70 megawatt điện. Vì những GPU này cần máy chủ và hệ thống làm mát để hoạt động, có thể nói rằng một trung tâm dữ liệu với 100,000 bộ xử lý Nvidia H100 sẽ tiêu thụ khoảng 100 megawatt điện. Đó là mức tiêu thụ điện tương đương với một thành phố nhỏ.

Musk nhấn mạnh rằng, mặc dù nguồn cung GPU tính toán đã là một rào cản đáng kể cho đến nay, nguồn cung điện sẽ trở nên ngày càng quan trọng trong một hoặc hai năm tới. Hai hạn chế này nhấn mạnh những thách thức trong việc mở rộng công nghệ AI để đáp ứng nhu cầu tính toán ngày càng tăng.

Mặc dù có những thách thức, sự tiến bộ trong kiến trúc tính toán và bộ nhớ sẽ cho phép huấn luyện các mô hình ngôn ngữ lớn (LLMs) ngày càng khổng lồ trong những năm tới. Nvidia đã giới thiệu Blackwell B200 tại GTC 2024, một kiến trúc GPU và nền tảng được thiết kế để mở rộng đến LLMs với hàng nghìn tỷ tham số. Điều này sẽ đóng vai trò quan trọng trong việc phát triển AGI.

Thực tế, Musk tin rằng một trí tuệ nhân tạo thông minh hơn con người thông minh nhất sẽ xuất hiện trong một hoặc hai năm tới. "Nếu bạn định nghĩa AGI là thông minh hơn con người thông minh nhất, tôi nghĩ đó là năm sau, trong vòng hai năm," Musk đã nói trong một cuộc phỏng vấn trên X Spaces.

Genk.

Chuyên Viên Lập Trình (AUTOMATION AI)

Công ty TNHH TOM Group Việt Nam

Location: Hồ Chí Minh

Salary: 14 Mil - 16 Mil VND

Chuyên viên Tuân thủ Công nghệ thông tin

Location: Hồ Chí Minh

Salary: Competitive

Chuyên viên Bảo mật Công nghệ thông tin

Location: Hồ Chí Minh

Salary: Competitive

Trưởng Bộ phận Tuân thủ Công nghệ thông tin

Location: Hồ Chí Minh

Salary: Competitive

Business Analysis Intern (BA Intern) / Thực tập sinh Phân tích Doanh nghiệp

Công ty TNHH Giải pháp Data V Tech

Location: Hồ Chí Minh

Salary: Competitive

Trưởng nhóm phân tích dữ liệu – Data Leader

Location: Hồ Chí Minh

Salary: Competitive

Chuyên viên SAP BA phân hệ FICO

Công Ty Cổ Phần Quốc Tế Sơn Hà

Location: Hà Nội

Salary: Competitive

Location: Hà Nội

Salary: Over 12 Mil VND

Chuyên gia An ninh công nghệ (Pentest)

CÔNG TY TÀI CHÍNH TÍN DỤNG TIÊU DÙNG TNHH MTV AEON

Location: Hà Nội

Salary: Competitive

Công Ty Cổ Phần GreenFeed Việt Nam

Location: Hồ Chí Minh

Salary: Competitive